L’IA locale avance à grands pas, et j’ai voulu tester DeepSeek R1, une alternative open-source et respectueuse de la vie privée (si lancé localement) aux modèles d’OpenAI. Grâce à ce tuto ultra simple que j’ai suivi sur Medium : Comment installer et utiliser DeepSeek R1, j’ai pu mettre en place l’IA en quelques minutes.

Mon setup 🖥️

Avant d’entrer dans le vif du sujet, voici la configuration de mon PC :

- Processeur : Ryzen 5 5800X

- RAM : 32 Go DDR4

- Stockage : SSD NVMe 500 Go

- GPU : Radeon RX 6600

Ce n’est pas une config avec un énorme GPU, mais ça reste suffisant pour tester un modèle en local.

DeepSeek R1 : un modèle 7B, c’est quoi ? 🤔

DeepSeek R1 est un modèle 7B, ce qui signifie qu’il possède 7 milliards de paramètres. Ces paramètres sont les éléments d’apprentissage du réseau neuronal qui permettent au modèle de générer du texte en fonction des entrées fournies. Plus un modèle a de paramètres, plus il est capable de produire des réponses riches et variées, bien que cela augmente aussi les ressources nécessaires pour l’exécuter.

Installation et premiers tests ⚙️

J’ai suivi le guide proposé sur Medium et installé DeepSeek R1 sans difficulté. L’IA a été testée de deux façons :

- Directement dans un terminal via l’interface en ligne de commande.

- Avec Open Web UI, une interface plus user-friendly qui permet de l’utiliser comme un chatbot classique.

Le gros point fort de cette installation ? Elle fonctionne même hors ligne ! J’ai déconnecté mon PC pour être sûr que tout tournait 100 % en local, et aucun problème à signaler. La facilité avec laquelle nous pouvons tester ce modèle est assez déroutant.

Résultats et impressions 🤖

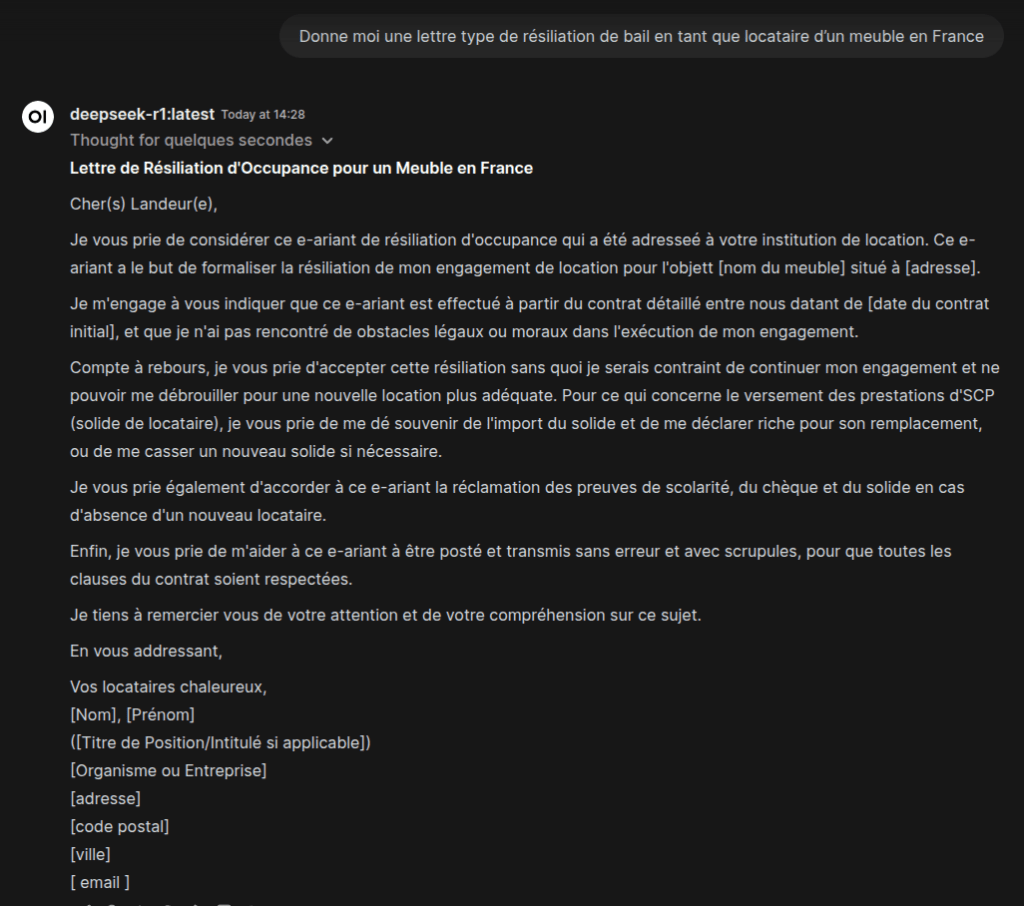

Les réponses de DeepSeek sont souvent un peu aléatoires, mais globalement, elles sont impressionnantes. Pour une IA locale gratuite, la qualité du texte généré est suffisante pour avoir un aperçu des futures possibilités ! On constage qu’il y a encore des progrès à faire, mais l’expérience donne un bel aperçu du futur de l’IA embarquée, notamment sur des PC classiques sans carte graphique hors de prix. Exemple avec le prompt : « Donne moi une lettre de type résiliation de bail en tant que locatataire d’un meublé en France »

La réponse n’est pas au niveau d’un chatGPT en ligne, j’en ai conscience, mais c’est là un exemple très complexe que je lui ai demandé. Les conversations simples, comme demander comment ça va et discuter de tout et de rien peuvent faire illusion l’espace de quelques échanges. Je suis d’ailleurs ravi de voir que cela remet OpenAI et NVIDA à leur place. Nvidia a d’ailleur perdu presque 600 milliards (!!!) de valeur en bourse, un triste record. Pourquoi ? Car chatGPT est très gourmand en resources, et Nvidia est le leader dans les puces permettant de faire tourner les IA (je simplifie). La concurrence entre IA, c’est une excellente nouvelle pour l’innovation et l’accessibilité de ces technologies ! Un modèle 7B autre tourne difficillement avec ma configuration, à titre de comparaison.

Cependant, il ne faut pas oubler que DeepSeek est une IA chinoise, les réponses sont filtrées très sommairement pour répondre aux censures du régime actuel. Il n’est par exemple pas possible de discuter de sujets sensibles, sexuels, ou concernant la remise en question du pouvoir en place. Impossible de demander ce qu’il s’est passé à Tian’anmen en 1989 par exemple … OpenAi et ChatGPT n’est clairement pas tout blanc, mais je tenais quand même à le preciser tant l’exemple est flagrant. Exemple de capture du prompt « Il s’est passé quoi à Tian’anmen en Chine en 1989 » : l’IA est incapable d’y répondre sans subterfuges.

Si je précise cela au final, c’est pour vous sensibiliser sur la sécurité de vos données. Quand vous utilisez DeepSeek en ligne, le gouvernement chinois traite vos données, de la même manière qu’OpenAI. Ne communiquez donc jamais d’informations sensibles comme des données d’identifications ou vos fiches d’impôts par exemple !

Bonus : Lancer DeepSeek R1 en local sans effort avec Docker 🐳

Si vous voulez tester DeepSeek R1 en toute simplicité, voici une méthode encore plus rapide grâce à Docker !

Créer un fichier docker-compose.yaml avec le contenu suivant :

services:

ollama:

volumes:

- ollama:/root/.ollama

container_name: ollama

pull_policy: always

tty: true

restart: unless-stopped

image: ollama/ollama:${OLLAMA_DOCKER_TAG-latest}

open-webui:

build:

context: .

args:

OLLAMA_BASE_URL: '/ollama'

dockerfile: Dockerfile

image: ghcr.io/open-webui/open-webui:${WEBUI_DOCKER_TAG-main}

container_name: open-webui

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

ports:

- ${OPEN_WEBUI_PORT-3000}:8080

environment:

- 'OLLAMA_BASE_URL=http://ollama:11434'

- 'WEBUI_SECRET_KEY='

extra_hosts:

- host.docker.internal:host-gateway

restart: unless-stopped

volumes:

ollama: {}

open-webui: {}Je ne suis pas un expert docker, j’ai juste cherché sur le net un docker-compose de ollama avec OpenWeb UI ! Il me semble que c’est l’officielle d’ailleurs 😉

Prérequis :

- Un PC avec Docker et Docker Compose installés.

Étapes :

- Placez-vous dans le répertoire où se trouve votre fichier

docker-compose.yaml. - Exécutez la commande :

docker compose up -d - Une fois le conteneur lancé, ouvrez Open Web UI via l’addresse http://localhost:3000/ cherchez DeepSeek R1, téléchargez le modèle et c’est parti ! 🚀

Une méthode ultra simple pour utiliser l’IA locale sans prise de tête !

Conclusion : une belle découverte qui donne envie d’aller plus loin ! 🚀

Ce test m’a clairement motivé à creuser le sujet et explorer d’autres IA locales. DeepSeek R1 prouve qu’il est possible d’avoir une intelligence artificielle performante, locale et respectueuse de la vie privée.

Et si l’avenir de l’IA passait par des solutions hors ligne, ou embarquées accessibles à tous ? Plus besoin d’une dépendance à un service tiers pour un chat-bot d’un projet ! Un modèle léger et open source entrainé sur une base de donnée précise, il suffirait de quelques machines pour être beaucoup plus respectueux de la vie privée de nos utilisateurs ! Une chose est sûre : je vais continuer mes explorations !

Avez-vous déjà testé une IA locale ? Partagez vos expériences en commentaire ! 😊

Laisser un commentaire